Un dispositivo che potrebbe ridurre di mille volte il consumo energetico dell'intelligenza artificiale

Lo studio “Experimental demonstration of magnetic tunnel junction-based computational random-access memory” pubblicato su npj Unconventional Computing da un team di ricercatori di ingegneria dell’università del Minnesota - Twin Cities e dell’università dell’Arizona – Tucson illustra un dispositivo hardware all'avanguardia che potrebbe ridurre di almeno 1.000 volte il consumo energetico per le applicazioni di elaborazione dell'intelligenza artificiale (IA).

I ricercatori hanno già e registrato diversi brevetti sulla tecnologia utilizzata nel dispositivo e spiegano che, data la crescente domanda di applicazioni AI, hanno cercato «Modi per creare un processo più efficiente dal punto di vista energetico, mantenendo al contempo elevate prestazioni e bassi costi. Comunemente, i processi di intelligenza artificiale o delle macchine trasferiscono dati tra logica (dove le informazioni vengono elaborate all'interno di un sistema) e memoria (dove i dati vengono archiviati), consumando una grande quantità di potenza ed energia».

Il team di ricercatori ha realizzato la computational random-access memory (CRAM), un nuovo modello in cui i dati non lasciano mai la memoria, e Yang Lv, del Dipartimento di ingegneria elettrica e informatica dell'università del Minnesota, sottolinea che «Questo lavoro è la prima dimostrazione sperimentale di CRAM, dove i dati possono essere elaborati interamente all'interno della matrice di memoria senza la necessità di lasciare la griglia in cui un computer memorizza le informazioni».

A marzo, l'International energy agency (IEA) ha pubblicato il report “Electricity 2024 - Analysis and forecast to 2026” che prevede cheil consumo energetico per l'IA probabilmente raddoppierà da 460 terawattora (TWh) nel 2022 a 1.000 TWh nel 2026. Il che equivale più o meno al consumo di elettricità dell'intero Giappone. Gli autori del nuovo studio stimano che «Un acceleratore di inferenza di apprendimento automatico basato su CRAM possa ottenere un miglioramento nell'ordine di 1.000. Un altro esempio ha mostrato un risparmio energetico di 2.500 e 1.700 volte rispetto ai metodi tradizionali».

Si tratta dei risultati di una ricerca durata oltre 20 anni e l’atro autore principale dello studio, Jian-Ping Wang che insegna al Dipartimento di ingegneria elettrica e informatica dell'università del Minnesota. ricorda che «La nostra idea iniziale di utilizzare le celle di memoria direttamente per l'elaborazione dati 20 anni fa era considerata folle. Con un gruppo di studenti in continua evoluzione dal 2003 e un vero team di docenti interdisciplinari creato presso l'università del Minnesota, dalla fisica, alla scienza e ingegneria dei materiali, all'informatica e all'ingegneria, alla modellazione e al benchmarking, fino alla creazione di hardware, siamo stati in grado di ottenere risultati positivi e ora abbiamo dimostrato che questo tipo di tecnologia è fattibile ed è pronta per essere incorporata nella tecnologia».

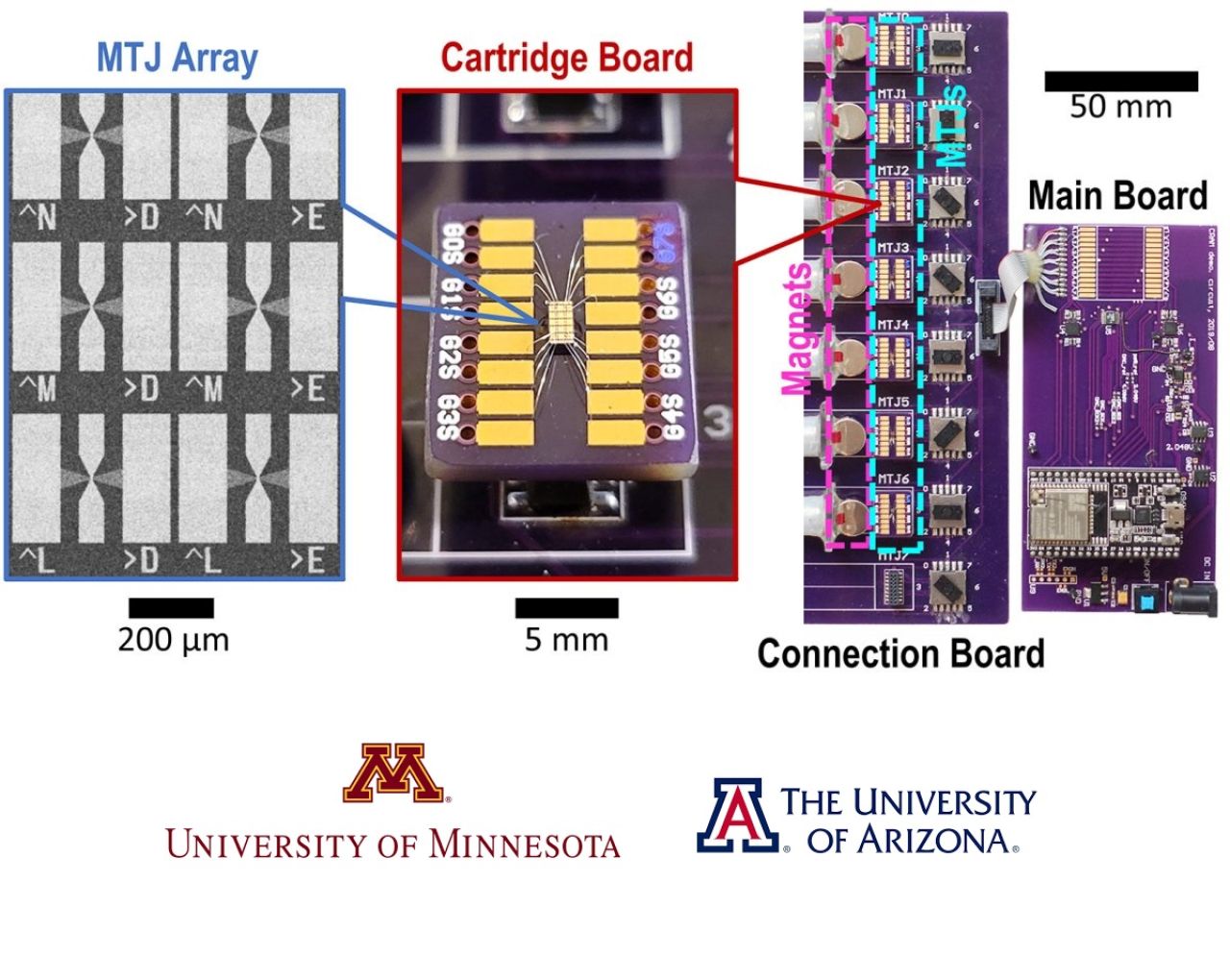

All’università del Minnesota evidenziano che «Questa ricerca fa parte di uno lavoro coerente e duraturo che si basa sulla ricerca innovativa e brevettata di Wang e dei suoi collaboratori sui dispositivi Magnetic Tunnel Junctions (MTJ), ovvero dispositivi nanostrutturati utilizzati per migliorare dischi rigidi, sensori e altri sistemi microelettronici, tra cui la Magnetic Random Access Memory (MRAM), utilizzata in sistemi embedded come microcontrollori e smartwatch. L'architettura CRAM consente il vero calcolo nella e tramite la memoria e abbatte il muro tra calcolo e memoria che costituiva il collo di bottiglia nell'architettura tradizionale di von Neumann, un progetto teorico per un computer a programma memorizzato che costituisce la base per quasi tutti i computer moderni».

Una delle autrici cdello studio, Ulya Karpuzcu, esperta di architettura informatica, e professoressa associata al Dipartimento di ingegneria elettrica e informatica dell’università del Minnesota, fa notare che «Come substrato di elaborazione in memoria digitale estremamente efficiente dal punto di vista energetico, CRAM è molto flessibile in quanto il calcolo può essere eseguito in qualsiasi posizione nell'array di memoria. Di conseguenza, possiamo riconfigurare CRAM per soddisfare al meglio le esigenze di prestazioni di un set diversificato di algoritmi di intelligenza artificiale. E’ più efficiente dal punto di vista energetico rispetto ai tradizionali elementi costitutivi per i sistemi di intelligenza artificiale odierni. La CRAM esegue i calcoli direttamente all'interno delle celle di memoria, utilizzando in modo efficiente la struttura dell'array, eliminando la necessità di trasferimenti di dati lenti e ad alto consumo energetico. Il dispositivo di memoria ad accesso casuale a breve termine, o RAM, più efficiente utilizza 4 o 5 transistor per codificare un 1 o uno 0 ma uno MTJ, un dispositivo spintronico, può svolgere la stessa funzione con una frazione di energia, con una velocità maggiore ed è resistente agli ambienti difficili. I dispositivi spintronici sfruttano lo spin degli elettroni anziché la carica elettrica per archiviare i dati, fornendo un'alternativa più efficiente ai tradizionali chip basati su transistor».

Attualmente, il team ha in programma di collaborare con i leader del settore dei semiconduttori, per fornire dimostrazioni su larga scala e produrre l'hardware per migliorare le funzionalità dell'intelligenza artificiale.